Por Cody Fenwick (Newsletter das 80.000 Hours)

A ideia desta semana: apesar das alegações de estagnação, a investigação em IA continuou a avançar rapidamente em 2024.

Há quem diga que a investigação em IA atingiu o seu ponto mais alto. No entanto, muitos indícios obtidos no último ano apontam na direcção oposta:

- Foram desenvolvidas e surgiram novas capacidades;

- A investigação indica que a IA existente pode acelerar o progresso científico.

E, ao mesmo tempo, foram publicadas importantes conclusões sobre a segurança e o risco da IA (ver abaixo).

Os avanços da IA poderão, eventualmente, vir a estagnar. Alguns especialistas nesta área alertaram para o facto de a falta de dados de qualidade, por exemplo, poder impedir um maior crescimento das capacidades, embora outros discordem. Seja como for, é evidente que o crescimento ainda não parou.

Entretanto, a previsão agregada no Metaculus de quando veremos o primeiro sistema de IA “geral” — que seria altamente capaz numa vasta gama de tarefas — é o ano 2031.

Tudo isto é extremamente relevante, pois a IA apresenta, potencialmente, riscos existenciais. Pensamos que garantir que a IA corre bem é um dos maiores e mais prementes problemas do mundo.

Se a IA continuar a avançar rapidamente, este trabalho será não só importante, mas também urgente.

Eis alguns dos principais desenvolvimentos no domínio da IA no último ano:

Novos modelos e capacidades de IA

A OpenAI anunciou, no final de Dezembro, que o seu novo modelo o3 conseguiu um grande avanço em termos de capacidades. Este baseia-se no modelo de linguagem o1 (também lançado em 2024), que tem a capacidade de deliberar sobre as suas respostas antes de responder. Com esta capacidade mais avançada, foi divulgado que o o3:

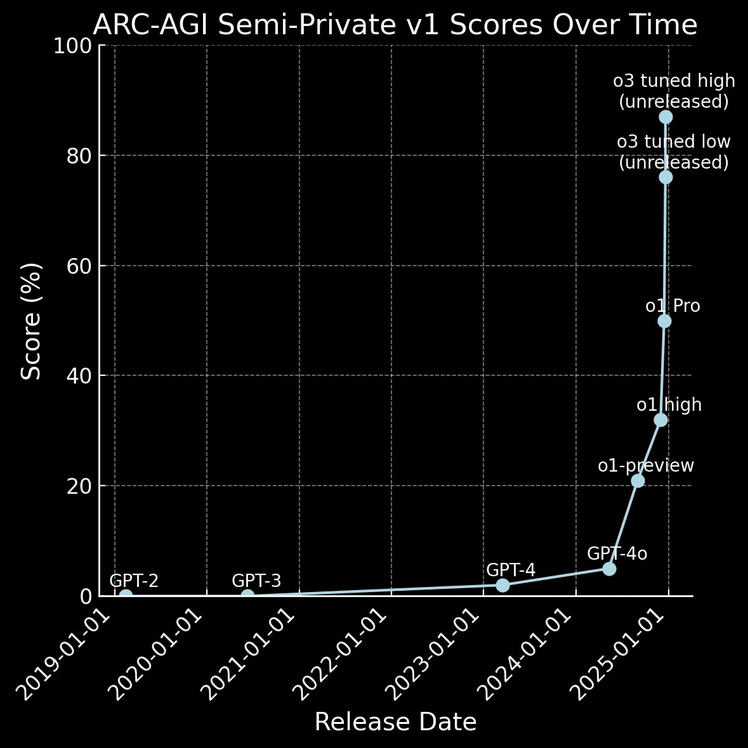

- Obteve uma pontuação revolucionária de 87,5% no ARC-AGI, um teste concebido para ser particularmente difícil para os principais sistemas de IA;

- Ultrapassou as fronteiras da engenharia de software de IA, obtendo uma pontuação de 71,7% num parâmetro de referência chave utilizando tarefas reais, em comparação com a precisão de 48,9% do o1;

- Obteve uma pontuação de 25% num novo (e extremamente difícil) teste de referência FrontierMath — enquanto os principais modelos de IA anteriores não conseguiam ultrapassar os 2%.

Pontuações no teste de referência ARC-AGI dos modelos da OpenAI desde 2019. Gráfico de Riley Goodside da ScaleAI.

Embora ainda não tenha sido lançado publicamente, parece claro que o3 é o modelo de linguagem mais capaz que já vimos. Apesar de ainda apresentar muitas limitações e fraquezas, este modelo desafia as alegações de que o progresso da IA estagnou em 2024.

Pode ser o avanço mais impressionante do ano, mas 2024 também trouxe muitos outros desenvolvimentos importantes:

- A geração de vídeos com IA registou um avanço significativo, com a OpenAI a lançar o Sora para utilização pública e a Google DeepMind a lançar o Veo;

- A Anthropic apresentou a funcionalidade de o seu chatbot Claude usar o computador do utilizador de acordo com as suas instruções;

- A Google DeepMind lançou o AlphaFold 3 — um sucessor de um sistema de IA vencedor do Prémio Nobel — que pode prever como as proteínas interagem com o ADN, o ARN e outras estruturas ao nível molecular;

- Os sistemas de IA estão cada vez mais aptos a receber dados áudio e visuais, bem como grandes volumes de texto, ao mesmo tempo que interagem com os utilizadores através de tecnologia de voz;

- Ao combinar os modelos AlphaProof e AlphaGeometry 2, a Google DeepMind conseguiu utilizar a IA para alcançar a medalha de prata nas Olimpíadas Internacionais de Matemática;

- A empresa chinesa DeepSeek afirmou que o seu modelo mais recente custou apenas 5,5 milhões de dólares para ser treinado — uma redução drástica face aos 100 milhões de dólares que a OpenAI gastou a treinar o GPT-4, com capacidades comparáveis.

Poderíamos incluir muito mais coisas nesta lista! Não ficaremos surpreendidos se, em 2025 e 2026, houver muitos mais avanços significativos nas capacidades de IA.

A ajuda da IA na ciência

Estudos recentes indicam que a IA pode ajudar a acelerar o progresso científico, incluindo a própria investigação sobre a IA:

- A IA parece ter melhorado os resultados do trabalho dos principais investigadores na área da ciência dos materiais em cerca de 80%, acelerando a sua capacidade de gerar novas ideias;

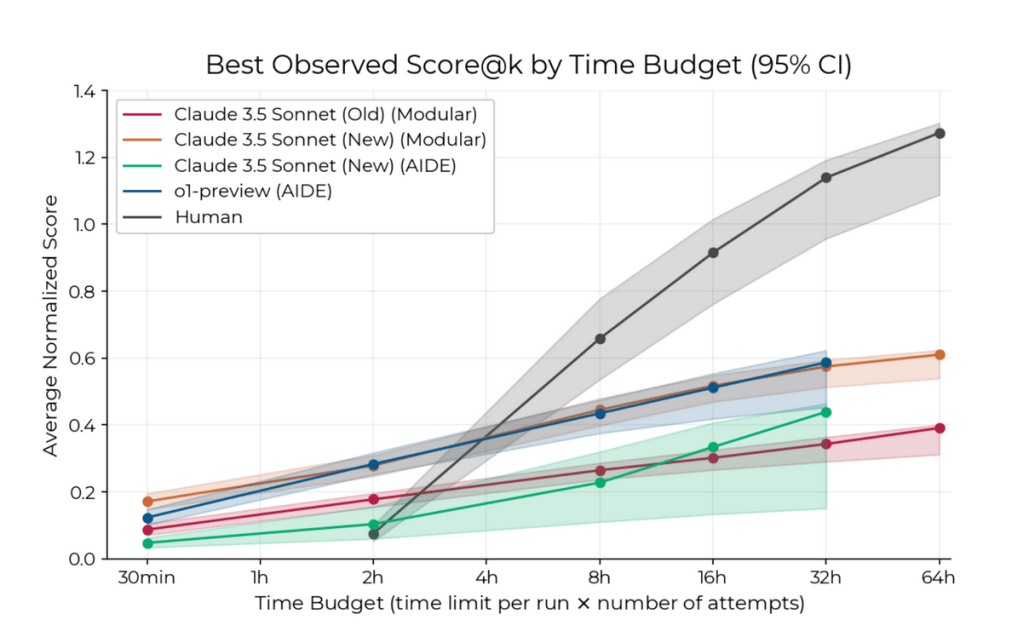

- Os agentes de IA podem superar os peritos humanos em tarefas de engenharia de investigação de aprendizagem de máquina (machine learning – ML),quando lhes é dado um prazo de duas horas, embora os seres humanos tendam a manter a liderança em períodos de tempo mais longos;

- Os investigadores descobriram que os modelos de linguagem parecem ser capazes de descobrir padrões fundamentais na bibliografia neurocientífica, tornando-os melhores do que os especialistas humanos na previsão dos resultados de novos estudos neste domínio.

As moléculas descobertas pela IA parecem ter mais probabilidades de passar a fase 1 dos ensaios clínicos.

O METR descobriu que, numa janela de tempo limitada, os grandes modelos de linguagem (LLM) podem superar os seres humanos numa amostra de tarefas de engenharia de investigação de aprendizagem de máquina (ML).

Alguns desenvolvimentos importantes na investigação sobre riscos e segurança da IA

Entretanto, assistimos a um misto de resultados encorajadores e preocupantes na investigação sobre a segurança da IA. Eis algumas das publicações importantes deste ano:

- Um artigo recente da Anthropic concluiu que os modelos de IA podem “fingir” estar alinhados com as intenções dos seus criadores quando lhes é dito que estão a ser treinados, abandonando esses comportamentos quando são implementados;

- A Apollo Research descobriu que, em determinadas condições, o modelo o1 da OpenAI tem a capacidade de planear para enganar os seus criadores e até fingir ser menos capaz do que é na realidade;

- Num artigo sobre “Agentes Adormecidos” (“Sleeper Agents”), os investigadores descobriram que os modelos de IA podem ter comportamentos enganadores e indesejados que o treino de segurança convencional não consegue eliminar;

- Uma nova abordagem para evitar o uso indevido da IA e melhorar o alinhamento envolve a aplicação de “disjuntores”, que visam directamente as representações internas de resultados nocivos, em vez de simplesmente tentar treinar os modelos para que estes se recusem a produzir resultados nocivos;

- A Anthropic informou que conseguiu identificar milhões de “características” — padrões de neurónios que podem estar associados a conceitos compreensíveis para o ser humano — num dos seus modelos de IA de ponta. Isto abre caminho para uma melhor compreensão do modo como estes sistemas realmente funcionam.

O que você pode fazer

Estes desenvolvimentos demonstram o ritmo acelerado e os potenciais riscos do avanço da IA. Para ajudar, você pode:

- Informar-se sobre os maiores riscos que a IA representa;

- Aprender a comunicar cuidadosamente sobre este tema;

- Descobrir formas de utilizar a IA no seu próprio trabalho;

- Considerar mudar de carreira para trabalhar na governação da IA ou na segurança da IA;

- Considerar outros potenciais empregos que possam ajudar.

Recomendamos ainda que consulte as publicações recentes do nosso fundador, Benjamin Todd, sobre:

- Oportunidades de financiamento na segurança da IA;

- Como é que as pessoas comuns podem preparar-se para a possibilidade de uma IA transformadora num futuro próximo

Tencionamos continuar a abordar este tópico no próximo ano e não ficaríamos surpreendidos se assistíssemos a muitas outras mudanças e desenvolvimentos importantes em matéria de IA. Continue a acompanhar-nos e considere a possibilidade de partilhar esta informação com os seus amigos, reencaminhando este e-mail caso o considere útil.

Mais informação:

- A escalada da IA pode continuar até 2030? da Epoch AI.

- O que acabou de acontecer: Um mês transformador reescreve as capacidades da IA por Ethan Mollick.

- Uma actualização da newsletter “Import AI” de Jack Clark: “O O3 da OpenAI significa que o progresso da IA em 2025 será mais rápido do que em 2024”.

- Os dados sintéticos são mais úteis do que se pensa por Lynnette Bye.

- Será que o progresso da IA está a abrandar? Compreender as recentes tendências e reivindicações tecnológicas por Arvind Narayanan e Sayash Kapoor.

- Coisas que ficámos a saber sobre os LLMs em 2024 por Simon Willison.

- Como a I.A. pode mudar a ciência para sempre — um vídeo de Cool Worlds

Publicado originalmente por Cody Fenwick na Newsletter das 80.000 Hours, a 3 de Janeiro de 2025.

Tradução de José Oliveira🔸.

Descubra mais sobre Altruísmo Eficaz

Assine para receber nossas notícias mais recentes por e-mail.