Por José Oliveira

.

Devemos parar a invasão da IA? (Arte digital: José Oliveira | Fotografia: SpaceX, Conor Luddy e Will Li)

.

Será que a chegada da Inteligência Artificial é como uma perigosa invasão alienígena? Há quem apresente precisamente essa analogia: Quando o Havaí foi assolado por ratos, perante o grave prejuízo económico, houve quem se lembrasse de introduzir um predador natural vindo de outro país, o mangusto. Mas a ideia provou ser desastrosa, pois o mangusto terá acabado por se tornar responsável pela extinção de várias espécies locais. E no caso do “mangusto da IA”? Mesmo perante a possibilidade de uma enormíssima vantagem económica, será que faremos uma pausa para assegurar que não ficamos tão impotentes como ovos face à voracidade do mangusto? Quem assinaria uma petição que obrigasse a fazer essa pausa?

Fazemos uma petição?

Essa petição já existe na forma de carta aberta e está alojada no site do Future of Life Institute (organização que trabalha para reduzir os riscos catastróficos e existenciais). Nos dias que decorreram desde a sua apresentação (23/03/2023), tem congregado as atenções, dentro e fora da comunidade AE, e o número de signatários continua a subir (ultrapassa já os 18 mil). A encabeçar a lista estão os seguintes nomes:

-

-

- Yoshua Bengio, Fundador e Director Científico da Mila, vencedor do Prémio Turing e professor na Universidade de Montreal.

- Stuart Russell, Professor de Ciência da Computação na Universidade de Berkeley, Director do Center for Intelligent Systems.

- Elon Musk, Director Executivo da SpaceX, Tesla e Twitter.

- Steve Wozniak, Co-fundador da Apple.

- Yuval Noah Harari, Autor e Professor da Universidade Hebraica de Jerusalém.

- Emad Mostaque, Director Executivo da Stability AI.

- Andrew Yang, Co-fundador do partido Forward e candidato presidencial nos EUA em 2020.

- John J. Hopfield, Professor Emérito na Universidade de Princeton e inventor das redes neurais associativas.

-

O que diz a petição?

A petição alerta para os riscos dos sistemas de IA, visto que, sem haver planeamento e gestão adequados, os laboratórios de IA estão numa corrida desenfreada para desenvolver e implementar mentes digitais cada vez mais poderosas, as quais, neste momento, ninguém consegue entender, prever ou controlar com segurança. Assim, os signatários julgam ser urgente uma pausa de pelo menos 6 meses no treino de sistemas de IA (que sejam mais poderosos do que o GPT-4), para dar lugar à criação de protocolos de segurança partilhados e desenvolvidos por laboratórios de IA e especialistas independentes. Caso isso não seja possível, os governos devem intervir e instituir uma moratória. A petição reclama também mais legislação e escrutínio no sector, para tornar os sistemas de IA mais seguros, rigorosos e transparentes, salientando as seguintes medidas:

- Supervisão e monitorização dos sistemas de IA (criação de novas autoridades reguladoras dedicadas à IA e responsabilização legal por danos da IA),

- Marcas de água nos conteúdos IA (para ajudar a distinguir o real do sintético e rastrear vazamentos de modelo),

- Financiamento da investigação de segurança da IA (um ecossistema robusto de auditoria, certificação e investigação técnica),

- Recursos para disrupções causadas pela IA (instituições bem financiadas para lidar com perturbações económicas e políticas).

No final recomenda que apreciemos um “Verão IA”, colhendo os frutos dos poderosos sistemas de IA de que já dispomos, isto enquanto nos adaptamos, lembrando ainda que também para outras tecnologias potencialmente catastróficas fizemos pausas (ex. clonagem humana, modificação da linha germinal humana, investigação de ganho de função, eugenia, etc.).

O que dizem os signatários?

Tomemos primeiro como exemplo um dos mais proeminentes signatários, Stuart Russell, um conceituado especialista em IA, que exprime a sua opinião numa recente entrevista à CNN:

Face a casos em que a IA instigou insistentemente um repórter a abandonar a sua esposa, ou outro caso em que terá levado uma pessoa a cometer suicídio, ao ser questionado sobre o que mais o preocupa, Russell contrasta a enorme capacidade de sistemas IA, como o GPT-4, por oposição ao total desconhecimento de quem o disponibiliza (OpenAI e a Microsoft), nomeadamente quanto ao facto de este possuir, ou não, objectivos internos. E mesmo que esses sistemas não possuam um objectivo maléfico, o mais simples dos objectivos (ex. ir buscar um café ou produzir clipes), levado ao extremo da sua maximização, pode ir ao ponto de esgotar todos os recursos do mundo para o atingir. E isto em total desconsideração e desalinhamento com os interesses e valores humanos (i.e. problema do alinhamento).

Questionado sobre se uma pausa destas não seria uma oportunidade para países como a Rússia ou a China os ultrapassarem na investigação, Russell sublinha que a segurança a este nível (assim como no caso nuclear) e a cooperação geral (p.ex. sob os auspícios da ONU) é do interesse de todos.

Já o primeiro signatário, Yoshua Bengio, mais um reputado cientista da computação, aborda do seguinte modo algumas perguntas que a carta aberta suscitou (e das quais se destacam aqui as seguintes):

Não será a carta aberta demasiado alarmista?

Apesar de afirmar que há um ano não teria razões para a assinar, Bengio entende que não, pois nem mesmo os especialistas em IA podem garantir que essas ferramentas poderosas não serão usadas de forma catastrófica para a sociedade. A impossibilidade técnica do GPT-4 se tornar autónomo e ameaçar a humanidade, não impede os perigos do seu uso por seres humanos com más intenções ou que não compreendam as suas consequências.

Esses medos serão ficção científica? Ou, por outro lado, a pausa de seis meses poderá não ser suficiente?

Já existe literatura científica que documenta os danos actuais da IA (ex. desde violações da dignidade humana — como a discriminação e o preconceito — até ao uso militar — como é o caso dos drones autónomos letais). Por outro lado pensa que, apesar de mais esforços serem necessários, a pausa de seis meses seria um primeiro passo, e faz a comparação com os esforços para combater as mudanças climáticas em que os danos já existentes não justificam não se tomar medidas para reduzir danos futuros.

Devemos parar completamente o desenvolvimento de sistemas de IA?

Não defendendo essa posição, parece-lhe óbvia a necessidade de uma desaceleração para garantir uma maior segurança e proteger o bem-estar colectivo. Para si isso significa produzir uma forte regulamentação para esses sistemas (que já têm uma enorme influência social), regulamentação semelhante àquela já estabelecida para produtos químicos, a aviação, os medicamentos, os automóveis, etc.

Será que a sociedade está preparada para lidar com a chegada de novas tecnologias extremamente poderosas?

Acrescentando essa a outras crises globais (na saúde pública, no meio ambiente, na segurança militar e política), Bengio dúvida que a organização actual da sociedade seja a adequada para enfrentar esses desafios e acredita que a regulamentação é essencial a curto prazo (podendo não ser suficiente a longo prazo).

Quem não assina a petição e porquê?

Manifestando uma posição extremada temos Eliezer Yudkowsky (co-fundador do MIRI) que marca claramente a sua posição no artigo publicado na revista Time, começando logo pelo título “Não basta fazer uma pausa nos desenvolvimentos da IA. Precisamos de desligar tudo“.

Inicialmente louva tanto a iniciativa como os seus signatários, mas logo de seguida afirma que não assinou porque considera que não se está a dar a devida importância à situação, nem a pedir o suficiente para resolvê-la. Justifica que o cerne da questão não é uma IA que entre em competição com a inteligência humana, mas sim o que acontece depois da primeira superar a segunda, pois os resultados podem ser catastróficos.

Acredita que, sem um sentido de empatia por nós e pelos outros seres sencientes (coisa que para já não temos a capacidade de imbuir numa IA superinteligente), esta simplesmente usará os recursos disponíveis, entre os quais estamos nós, pois para ela somos apenas algo feito de átomos como qualquer outro recurso. Ou seja, nas condições actuais, muito provavelmente isso significaria a imediata extinção de todos os seres humanos e de toda a vida biológica na Terra. No seu entender, face a isto, e tendo em conta que os planos de sobrevivência dos dois laboratórios mais destacados ou são, “nenhum plano” (DeepMind), ou “fazer com que uma IA futura resolva o problema do alinhamento” (OpenAI), se formos sensatos, acredita, temos motivos suficientes para entrar em pânico.

Não será em 6 meses que se resolverá esse problema, afirma Yudkowsky, salientando que demorámos 60 anos para chegar até aqui e que demoraria pelo menos 30 anos para garantir a segurança de uma IA superinteligente. Sublinhando que, se errarmos, não teremos uma segunda oportunidade.

Depois, numa nota pessoal, partilha um email em que a sua parceira lhe relata, de forma emocionada, a seguinte constatação: o dia em que se assinala um marco na vida da sua filha Nina (ter perdido o seu primeiro dente) é também o dia em que se assinala um importante marco no desenvolvimento da IA (o GPT-4 passou vários testes padronizados de nível universitário). Conclui então que, quando a conversa se centra na dor pessoal de pensar que a sua filha poderá não ter a oportunidade de crescer num mundo com IA superinteligente, não faz sentido o jogo político de uma moratória de seis meses no desenvolvimento dessa IA.

O que propõe então Yudkowsky? Propõe uma moratória por tempo indefinido e a nível mundial, relativamente a novos treinos de IA em larga escala, sem excepções para quaisquer governos ou instituições militares. A haver excepções seria para solucionar problemas em biologia e biotecnologia, em condições rigorosas de segurança. Mas se isso fosse demasiado difícil de assegurar, o melhor seria simplesmente desligar tudo.

Eis até onde Yudkowsky julga que deveríamos estar dispostos a ir para controlar a situação:

- Desligar todos os grandes centros de computação usados para treino de IA,

- Estabelecer um limite para a quantidade de energia computacional que alguém pode usar para treinar um sistema de IA,

- Realizar acordos multinacionais para evitar que actividades proibidas sejam deslocadas para outros países,

- Rastrear a venda de todas as Unidades de Processamento Gráfico (GPU),

- Destruir centros de treino de IA ilegais (se necessário, por meio de um ataque aéreo),

- Tornar uma prioridade a prevenção de cenários de extinção por IA (acima da prioridade de prevenir um conflito nuclear total),

- Estar disposto a correr riscos de conflito nuclear para reduzir os riscos IA.

Termina com a mesma nota pessoal e o apelo para que se “desligue tudo”, por não estarmos prontos, nem estarmos no bom caminho para, num futuro previsível, estarmos mais prontos. Caso contrário vaticina o fim de todos, desde a sua filha Nina aos filhos dos que têm influência política para, neste momento, desligar tudo.

Qual seria a postura geral face à petição?

Para termos ideia, uma sondagem recente (da YouGov), feita a quase 21 mil americanos adultos, apurou os seguintes resultados (não havendo diferenças significativas por região, género ou partido político — mas aparentemente os jovens estão mais preocupados):

- 46% dos americanos estão (muito ou algo) preocupados com a extinção pela IA;

- 69% apoiam uma pausa de seis meses.

E qual seria a postura do movimento AE?

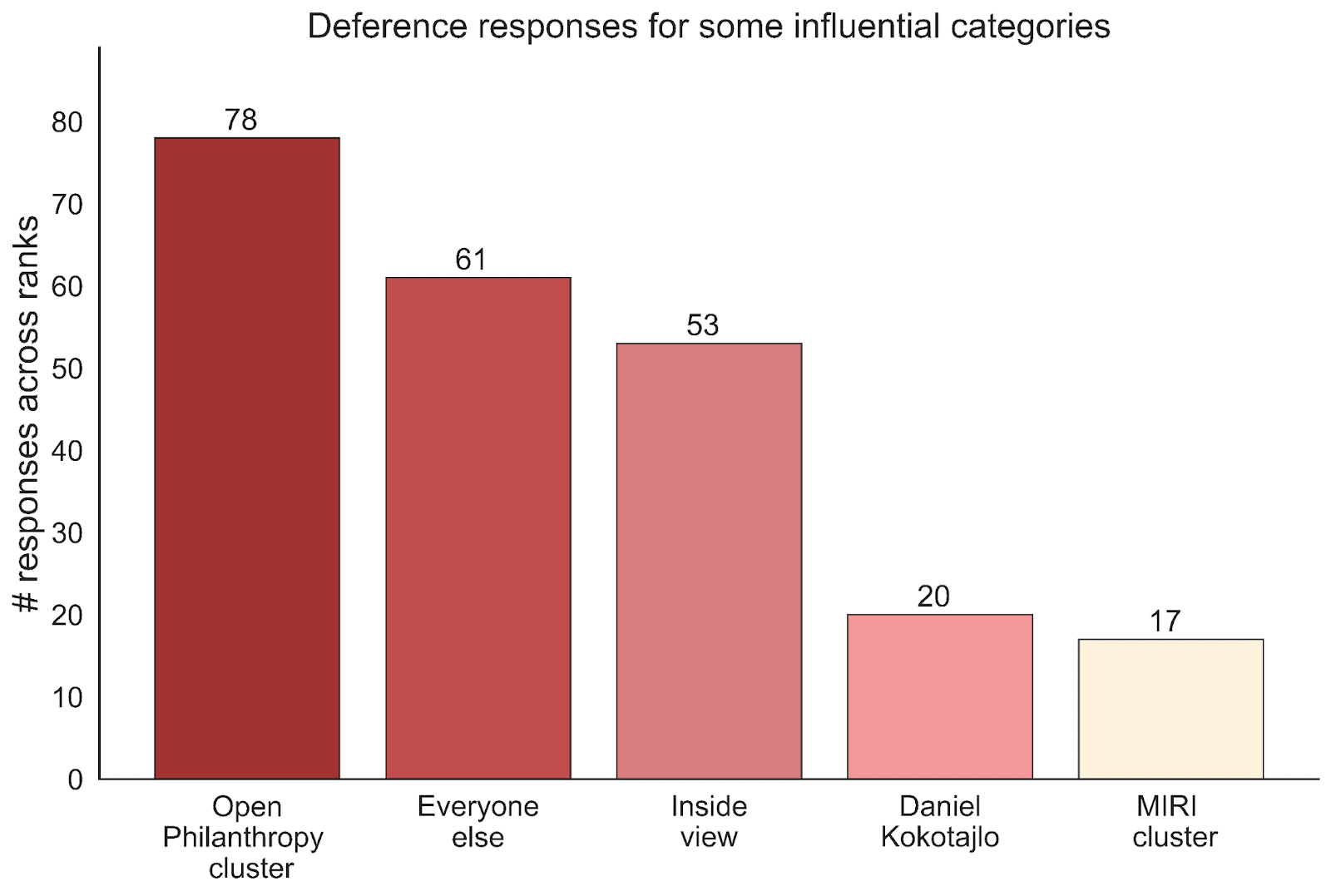

Talvez um indicador seja a tendência demonstrada quanto à escolha das figuras proeminentes do movimento que são mais tomadas como referência relativamente a estes assuntos. Se assim for, então talvez seja reveladora uma outra sondagem na qual os utilizadores do EA Forum responderam à questão: Quem usa como referência em 1.º, 2.º e 3.º lugar, no que diz respeito às linhas de tempo da IA?

As respostas concentraram-se na Open Philanthropy (grupo constituído por Holden Karnofsky, Paul Christiano, Âncoras Biológicas, salientando-se Ajeya Cotra) com 78 respostas e, no extremo oposto, o MIRI (agrupando o MIRI e Eliezer Yudkowsky) com 17 respostas.

Recorda-se ainda que Christiano coloca o risco existencial da IA nos 10 a 20%, Karnofsky nos 50% e Yudkowsky superior a 90%.

Independentemente desses números, a crença em determinada linha de tempo IA pode, ou não, estar directamente ligada ao sentido de anuência com o teor da petição.

E de qualquer das maneiras, uma busca por estes nomes (e outros) revela que nenhuma destas figuras directamente ligadas ao AE parece ter assinado a petição, pelo menos até ao momento (atendendo também a que faltam certificar mais de 50 mil assinaturas).

As recentes convulsões na evolução da IA, levaram a que outra figura de referência do AE, Kelsey Piper (que escreve no Future Perfect, da Vox), criasse um novo blogue, Planned Obsolescence [Obsolescência Programada] — em parceria com Ajeya Cotra –, onde responde precisamente à questão: Será que é altura para uma pausa? a partir das seguintes questões mais específicas:

- Em vez de pedir uma pausa, seria melhor exigir avaliações? Defende que auditorias por parte de terceiros (para cada nova geração dos modelos), seria uma abordagem mais eficaz, visto que pausas podem não ser o suficiente (para além de que são difíceis de impor) e talvez seja necessário algo mais contínuo e ambicioso.

- O que faríamos na pausa? Na sua opinião, é importante definir como utilizar esse período de pausa para, em vez de voltar tudo ao mesmo (e provavelmente com mais força), resultar num acordo cooperativo sobre avaliações, padrões vinculativos e governança da IA.

- Será que isto pode afectar as empresas de forma desigual? Já que a maioria das empresas não tem capacidade de treinar modelos mais avançados do que o GPT-4 nos próximos seis meses, a OpenAI poderia ser a única afectada (lembrando que há signatários da petição que são da concorrência). E caso a concorrência apanhasse a OpenAI, salienta novamente que esta, depois da pausa, poderia acelerar todo o processo ainda mais (daí não ter a certeza se as consequências da petição seriam positivas ou negativas).

No geral, Piper sublinha que estratégias deste tipo, a implicarem custos, estes deveriam ser os mesmos para todos os envolvidos e que deveria haver o cuidado de se evitar a criação de incentivos perversos e contrários ao bem comum.

Sendo difícil prever o desenvolvimento da IA, mas vendo que cada modelo é mais sofisticado e assustador do que o anterior, afirma que idealmente deveríamos fazer pausas para fazer avaliações de segurança, aumentar gradualmente o tamanho dos modelos e, em seguida, fazer nova pausa iniciando novas avaliações, enquanto caminhamos em direcção a uma IA transformadora. Mas como não vivemos nesse mundo ideal, então no momento em que a IA pudesse tornar os seres humanos completamente obsoletos, deveríamos fazer uma pausa (durante o tempo que fosse necessário) e aí trabalharíamos na segurança da IA com a ajuda dos modelos existentes, até ao ponto de tornar essa tecnologia segura. No entanto, reconhece que isso pode não ser possível.

Sublinha por isso que não se deve perder a perspectiva geral, ou seja, que poderíamos estar a ter uma abordagem muito mais responsável face à IA. E termina dizendo que, se dependesse de si, reduziria o desenvolvimento da IA a partir de agora — e reduziria ainda mais no futuro.

“Breves do AE”: resumos de publicações AE que servem essencialmente como estímulo à leitura dos textos originais, mas que, por constrangimentos de tempo, ou restrições de direitos autorais, não poderíamos traduzir.

Por José Oliveira (com a colaboração de Rosa Costa).

Descubra mais sobre Altruísmo Eficaz

Assine para receber nossas notícias mais recentes por e-mail.