Por José Oliveira

.

A IA é uma “Tragédia dos Comuns”? (Arte digital: José Oliveira | Fotografia: Werclive; Louis Maniquet)

.

A IA é um caso de “Corrida às armas” ou de “Tragédia dos Comuns”? Vejamos o primeiro caso, em que se corre para chegar primeiro à meta, não vá o inimigo lá chegar primeiro (como no caso da corrida para desenvolver a 1.ª bomba atómica). Talvez essa não seja a analogia mais correcta, pois na IA há várias metas (em vez do objectivo único da bomba atómica, seria mais como a aplicação alargada da electricidade), mas para além dos potenciais benefícios durante a corrida, aquele que corta a meta e ganha pode ser a própria IA (o que significa que, caso a IA não esteja alinhada com os nossos interesses, uma das partes ao acelerar o passo para a meta pode estar a acelerar o passo para a morte de todos). E o que dizer da analogia da “Tragédia dos Comuns”? Este termo é aplicado, nomeadamente por ecologistas e economistas, relativamente à extinção de recursos promovida por uma parte, levando ao prejuízo de todos. De que modo isto se aplicaria à IA?

É o que veremos de seguida através das ideias propostas por Sigal Samuel, uma repórter do Future Perfect da Vox.

Mas antes disso, vejamos algumas actualizações no âmbito da IA.

O que há de novo na IA?

17/04/23 — 12 ideias provisórias para a política de IA dos EUA a Open Philanthropy lança 12 sugestões para se legislar no sector da IA:

- Controlo das exportações de software que possam constituir um risco na proliferação de IA avançada.

- Exigir características de segurança do hardware nos chips mais avançados (nos que estão já em uso e nos futuros).

- Controlar a existência e o movimento de chips mais avançados e licenciar os grandes centros de computação.

- Acompanhar e exigir uma licença para desenvolver modelos de IA mais avançados.

- Requisitos de segurança da informação, para limitar a proliferação não intencional de modelos perigosos.

- Requisitos de teste e avaliação mais rigorosos, incluindo uma avaliação por um auditor independente que cumpra determinados critérios.

- Financiar géneros específicos de I&D em matéria de alinhamento, interpretabilidade e avaliação de modelos.

- Financiar a I&D sobre segurança defensiva da informação, mais uma vez para ajudar a limitar a proliferação não intencional de modelos perigosos.

- Criar um espaço restrito de protecção anti-monopólio para favorecer a colaboração em matéria de segurança da IA.

- Exigir a comunicação de certos tipos de incidentes de IA, à semelhança de outros sectores (p. ex. aviação).

- Tornar mais clara a responsabilidade legal dos criadores de IA face a danos concretos causados pela IA, nomeadamente danos físicos ou financeiros evidentes, incluindo os resultantes de práticas de segurança negligentes (para incentivar um maior investimento nesse âmbito).

- Criar meios para o rápido encerramento de grandes centros de computação em caso de emergência.

09/05/23 — Porque é que o “padrinho da IA”, Geoffrey Hinton, pensa que a humanidade está numa encruzilhada: numa entrevista ao The Guardian Geoffrey Hinton explica que abandonou a Google para poder falar abertamente sobre as suas preocupações face aos avanços na IA e como esta pode ser uma ameaça existencial para a espécie humana.

24/05/23 — Será possível construir com segurança algo que nos pode matar? Kelsey Piper considera que Sam Altman, da OpenAI, se refere a Planear a IAG [Inteligência Artificial Geral] e mais além como uma “corrida às armas” em que o compromisso entre legislar de forma demasiado apertada (o que poderia permitir que outros obtenham uma IAG primeiro), e legislar de forma demasiado aberta (o que poderia permitir a criação de uma IAG que nos destrua), parece ser um compromisso inviável face a tantas solicitações de aceleração sem realmente termos um plano de “governança da superinteligência”.

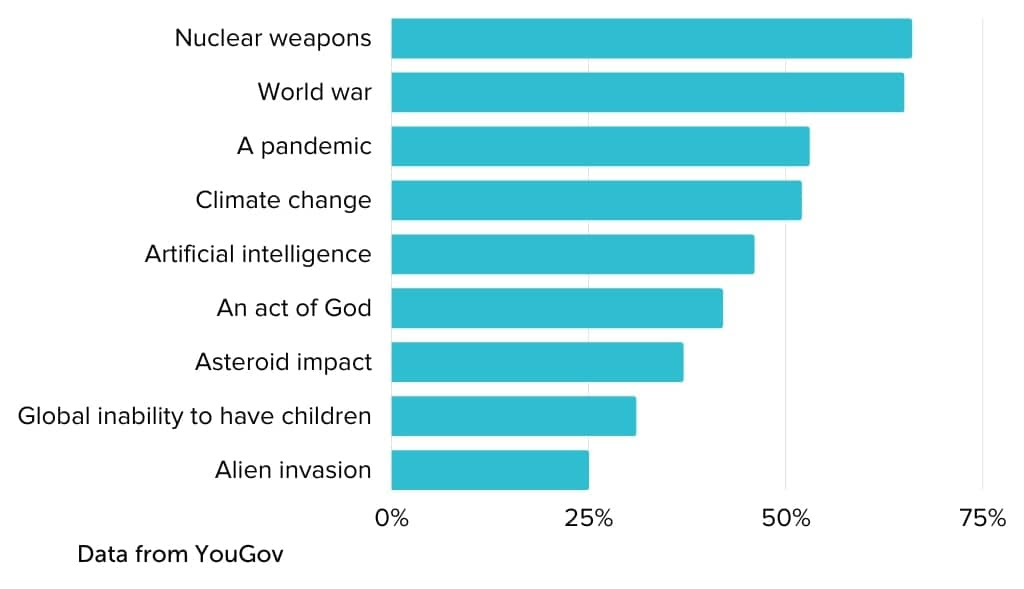

26/05/23 — O público está mais preocupado do que se pensava com a possibilidade de extinção causada pela IA, diz-nos as 80.000 Hours na sua Newsletter:

30/05/23 — Declaração sobre os riscos da IA, Center for AI Safety, O CAIS lança uma curta declaração que visa ultrapassar as dificuldades em exprimir preocupações sobre alguns dos riscos mais graves da IA avançada e abrir o debate. Destina-se também a trazer ao conhecimento do público o número crescente de especialistas e figuras públicas que levam a sério alguns desses riscos e por isso são signatários da seguinte declaração:

Atenuar o risco de extinção da IA deve ser uma prioridade global, a par de outros riscos à escala planetária, como as pandemias e a guerra nuclear.

23/06/23 — Revista Asterisk, n.º3, IA. Neste número que aborda a IA, eis alguns dos artigos:

- Porquê preocuparmo-nos? Os Editores

- Crescer de um dia para o outro Um olhar sobre os últimos anos de progresso dos modelos de linguagem de larga escala (LLM).

- A IA não irá conquistar os empregos no sector da tecnologia — para já, por Jonathan Mann. os LLM podem tornar o trabalho de um programador mais fácil e rápido. Mas quando irá torná-lo obsoleto?

- Teste de impacto com o GPT-4, por Beth Barnes (entrevista). Podemos saber se um modelo de IA é seguro antes de ser lançado? O grupo que testou o GPT-4 está a tentar descobrir como.

- Onde erramos quanto à IA e a China, por Jeffrey Ding (entrevista). Toda a gente tem medo daquilo que a China pode e vai fazer com a IA. No terreno, o cenário parece muito mais complexo.

- Um guia de campo para a segurança da IA, por Kelsey Piper. A segurança da IA está a começar a tornar-se mainstream, mas os investigadores que estiveram imersos nela durante mais de uma década ainda têm fortes divergências.

- Através de um vidro escuro, por Scott Alexander. Ninguém previu a revolução da IA, à excepção dos 352 especialistas a quem foi pedido que a previssem.

- Quanto tempo falta para o Apocalipse?, por Michael Gordin. Os cientistas, generais e políticos não conseguiram prever com exactidão quando é que os soviéticos iriam criar a bomba. Será que poderiam ter feito melhor?

- Seremos suficientemente inteligentes para saber quão inteligentes são as IA?, por Robert Long. Os cientistas falharam repetidamente em reconhecer a complexidade da cognição animal. Será que vamos cometer os mesmos erros com a IA?

- Continua…

11/07/23 — A IA superinteligente vai acabar com o mundo? A palestra TED de Eliezer Yudkowsky já corria na internet há várias semana, mas acaba de ser publicada:

Será mais correcto ver a situação como “tragédia dos comuns”?

Retomemos então o tópico: a IA é como uma “corrida às armas” ou como uma “tragédia dos comuns”? Embora alguns dos exemplos anteriores pressuponham a primeira hipótese, vejamos a analogia que Sigal Samuel apresenta a favor da segunda. Ela compara a capacidade da sociedade absorver os impactos da IA com a capacidade da Terra absorver as emissões de gases de efeito de estufa. E aí, se cada companhia agisse na presunção de que o prejuízo que pudesse assumir (face a esse bem comum) acabasse por ser um benefício para outra companhia, então, não assumindo cada uma a sua cota parte da responsabilidade, o prejuízo seria de todos — fosse no caso da catástrofe climática, fosse no caso da tragédia tecnológica.

Qual é a solução para a “tragédia dos comuns”?

Embora o termo “tragédia” seja assustador, Sigal alega que, pelo contrário, há razões para optimismo ao enquadrar a IA desse modo, visto que já possuímos soluções para este tipo de problemas. De facto, a Cientista Política, Elinor Ostrom, venceu o prémio Nobel da Economia, em 2009, precisamente por apresentar soluções para esse problema.

Face a visões mais pessimistas, nas quais se incluem as do autor que popularizou o termo “tragédia dos comuns”, Garrett Hardin, e que previam que “A ruína é o destino para o qual todos os homens correm, cada um perseguindo o seu próprio interesse”, Ostrom, baseada no seu estudo de comunidades da Suíça às Filipinas, observou que haviam alguns princípios básicos que estas comunidades usavam para evitar a “tragédia dos comuns” e enumerou-os do seguinte modo:

- Definir claramente a comunidade que gere o recurso.

- Assegurar que as regras estabelecem um equilíbrio razoável entre a utilização do recurso e a sua manutenção.

- Envolver todos aqueles que são afectados pelas regras no processo de elaboração das mesmas.

- Estabelecer mecanismos de controlo da utilização e do comportamento dos recursos.

- Criar uma série de sanções cada vez mais severas para quem infringir as regras.

- Estabelecer um procedimento para a resolução dos conflitos que possam surgir.

- Assegurar que as autoridades reconhecem o direito da comunidade a organizar-se e a estabelecer regras.

- Incentivar a formação de múltiplas estruturas de governação em diferentes escalas para permitir diferentes níveis de tomada de decisões.

Como aplicar esses princípios à IA?

Bom, Sigal Samuel acredita que já há quem esteja a defender estes princípios no domínio da IA, mesmo que não estejam cientes disso. Por exemplo, já há quem defenda, como Avital Balwit, que se deve rastrear os chips usados nas IA mais avançadas e assegurar que quem os usa deve respeitar normas estritas de segurança — o que corresponderia ao 4.º princípio de Ostram, “Estabelecer mecanismos de controlo da utilização e do comportamento dos recursos”.

Há também quem advogue, como é o caso de Tristan Harris e Aza Raskin, que uma das únicas maneiras das empresas cumprirem normas de segurança é sob a ameaça de graves sanções legais — o que corresponderia ao 5.º princípio de Ostram, “Criar uma série de sanções cada vez mais severas para quem infringir as regras”.

E mesmo perante quem defende a “corrida às armas” para não perdermos face à China, há ainda quem defenda, como Katja Grace, a coordenação internacional semelhante aos tratados de não proliferação do armamento nuclear — o que corresponderia ao 8.º princípio de Ostram, “Incentivar a formação de múltiplas estruturas de governação em diferentes escalas para permitir diferentes níveis de tomada de decisões”.

Mas então se as pessoas já estão a adoptar os princípios de Ostram, mesmo que inadvertidamente, qual é a necessidade de evidenciar essa relação?

Sigal defende duas razões para o fazer, 1) poderíamos passar a aplicar não dois ou três, mas todos os princípios de Ostram e 2) compreendendo a importância das narrativas, poderíamos contrariar a narrativa da “corrida às armas”, que nos deixa a todos em pior situação, e poderíamos passar a contar uma outra história, que embora envolva uma potencial “tragédia dos comuns”, essa tragédia, sendo apenas potencial, poderia ser reescrita terminando com um final feliz.

“Breves do AE”: resumos de publicações relacionadas com o AE que, por constrangimentos de tempo, ou restrições de direitos autorais, não poderíamos traduzir. Estes resumos servem essencialmente como estímulo à leitura dos textos originais aqui referidos.

Por José Oliveira.

Descubra mais sobre Altruísmo Eficaz

Assine para receber nossas notícias mais recentes por e-mail.